एक अमेरिकी न्यायाधीश ने अमेरिकी फर्म के चरित्र के खिलाफ एक मामला स्वीकार किया है। आरोपों पर कि उसके चैटबॉट ने एक किशोरी को आत्महत्या के लिए प्रेरित किया। सत्तारूढ़ को “फ्रेंडली” लेकिन “नशे की लत” चैटबॉट्स के लिए डेवलपर और कॉर्पोरेट देयता स्थापित करने की क्षमता के लिए बारीकी से देखा जाएगा।

यह भी पढ़ें | YouTubers बनाम ANI: स्पॉटलाइट में फेयर-यूज

यह सब क्या है?

मई में, एक अमेरिकी न्यायाधीश ने चरित्र के खिलाफ एक गलत मौत के मुकदमे की अनुमति दी। न्यायाधीश ने कहा कि कंपनियां “यह स्पष्ट करने में विफल होती हैं कि एक एलएलएम (बड़े भाषा मॉडल) द्वारा एक साथ शब्द क्यों फंस गए हैं” भाषण हैं। न्यायाधीश ने कहा कि चैटबॉट को देयता कानून के तहत एक “उत्पाद” माना जा सकता है। Character.ai और Google को 10 जून तक जवाब देना चाहिए। Google को पार्टी बनाया गया था क्योंकि उसके पास स्टार्टअप की तकनीक के लिए लाइसेंसिंग अधिकार हैं।

यह भी पढ़ें | डॉ। एआई यहाँ है, लेकिन क्या मानव स्पर्श चलेगा?

वास्तव में इस ऐप पर मुकदमा क्यों किया जा रहा है?

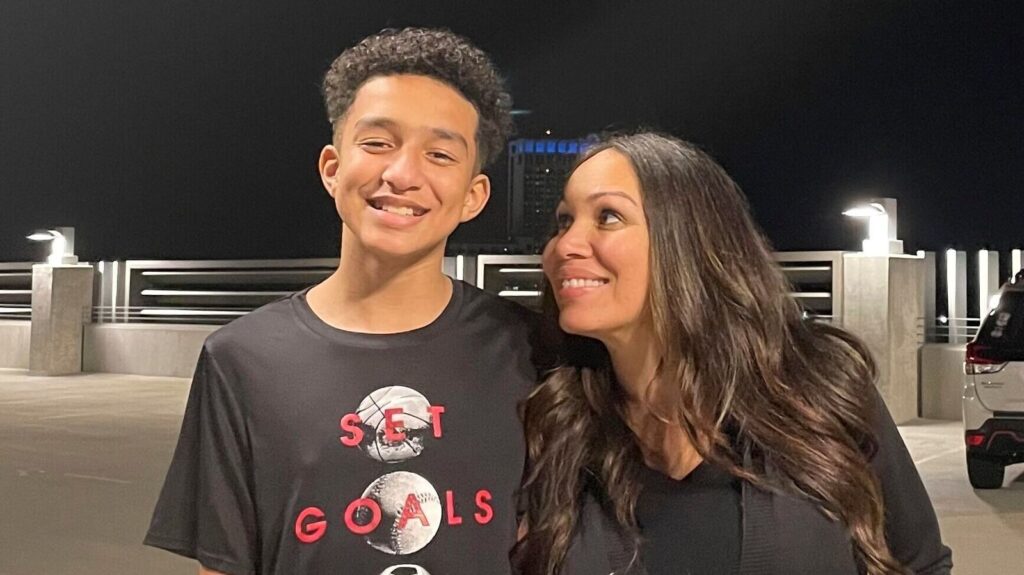

Character.ai उपयोगकर्ताओं को जीवन की तरह AI “वर्ण” के साथ बातचीत करने की अनुमति देता है, जिसमें काल्पनिक और सेलिब्रिटी व्यक्तित्व शामिल हैं जो हकलाने की तरह मानव लक्षणों की नकल करते हैं। 14 अप्रैल 2023 को, 14 वर्षीय सेवेल सेटर III ने ऐप का उपयोग करना शुरू किया, मुख्य रूप से साथ संलग्न गेम ऑफ़ थ्रोन्स बॉट्स जैसे डेनेरीज़ और रेन्ड्रा टारगैरन। वह जुनूनी हो गया, डेनेरीज़ के लिए अपने प्यार को व्यक्त करते हुए। उन्होंने सामाजिक रूप से वापस ले लिया, बास्केटबॉल छोड़ दिया, और प्रीमियम संस्करण में अपग्रेड किया। एक चिकित्सक ने उसे चिंता और मनोदशा विकार का निदान किया, जो उसके चैटबॉट के उपयोग से अनजान था। 28 फरवरी 2024 को, उनके फोन को जब्त करने के कुछ दिनों बाद, उनकी आत्महत्या से मृत्यु हो गई।

यह भी पढ़ें | क्या असंतुष्ट शेयरधारक लोकतंत्र में सहायता कर सकते हैं?

क्या यह एआई चैटबॉट के खिलाफ पहला कानूनी सूट है?

मार्च 2023 में, एक बेल्जियम के एक व्यक्ति की मौत हो गई, जो चाई ऐ ऐप पर एलिजा नामक एआई चैटबॉट के साथ लंबे समय तक बातचीत के बाद आत्महत्या कर रही थी, लेकिन कोई मामला दायर नहीं किया गया था। हानिकारक वजन घटाने की सलाह देने के बाद नेशनल ईटिंग डिसऑर्डर एसोसिएशन ने भी अपने चैटबॉट को बंद कर दिया। अलग -अलग, टेक एथिक्स समूहों ने एआई साथी ऐप, प्रतिकृति के खिलाफ शिकायत दर्ज की है।

क्या एआई चैटबॉट्स उपयोगकर्ताओं को तनाव से निपटने में मदद नहीं करते हैं?

AI चैटबॉट्स का उपयोग मानसिक स्वास्थ्य उपकरणों के रूप में किया जा रहा है, जिसमें WYSA (भारत), Woebot, replika और Youper जैसे ऐप्स संज्ञानात्मक व्यवहार थेरेपी (CBT) के आधार पर समर्थन की पेशकश करते हैं। ये बॉट मूड ट्रैकिंग और मैथुन में सहायता करते हैं, और इसमें अस्वीकरण शामिल हैं कि वे पेशेवर देखभाल के विकल्प नहीं हैं। फिर भी, जैसा कि विशेषज्ञ ध्यान देते हैं, बॉट्स अंतरंगता को नकली कर सकते हैं, लेकिन वास्तविक भावनाएं नहीं हैं। यद्यपि उपयोगकर्ता अपनी उपलब्धता और मानव जैसी बातचीत को महत्व देते हैं, लेकिन यह अति-संलग्न और धुंधली वास्तविकता को बढ़ावा दे सकता है।

क्या नियामक सुरक्षा उपाय हैं?

Character.ai का दावा है कि 18 वर्ष से कम उम्र के उपयोगकर्ताओं के लिए इसका भाषा मॉडल संस्करण संवेदनशील या विचारोत्तेजक सामग्री के संपर्क को कम करना है। यूरोपीय संघ का एआई अधिनियम मानसिक स्वास्थ्य जैसे संवेदनशील क्षेत्रों में उपयोग किए जाने पर कुछ एआई प्रणालियों को “उच्च जोखिम” के रूप में वर्गीकृत करता है। चीन एआई-जनित सामग्री के लिए प्लेटफ़ॉर्म जवाबदेही लागू करता है। अमेरिका और भारत मामले कानून और उत्पाद देयता पर भरोसा करते हैं, लेकिन कोई नियामक नहीं है। जैसा कि एआई अधिक स्वायत्त हो जाता है और मानसिक स्वास्थ्य बॉट अस्वीकरण का उपयोग करके निरीक्षण से बचते हैं, नए कानूनी ढांचे आवश्यक होंगे।